Apple ogłosiło zmiany, jakie niedługo zamierza wprowadzić w funkcjonowaniu swych systemów operacyjnych, w tym nowe funkcje "ochrony dzieci" dla usług iCloud i iMessage. Jeśli pamiętacie wojnę o dostęp do silnej kryptografii, wiecie co to oznacza: Apple planuje wyposażyć swoje systemy przechowywania danych i przesyłania wiadomości w zapadnię (backdoor).

Wykorzystywanie dzieci to poważny problem, a Apple nie jest pierwszą firmą IT, która nagina swoje podejście w zakresie ochrony prywatności próbując walczyć z tym procederem. Ta decyzja mocno odbije się jednak na użytkownikach.

TELL APPLE: DON'T SCAN OUR PHONES

Apple może szeroko rozwodzić się o tym, jak projektowany przez nich backdoor będzie chronić w praktyce prywatność i bezpieczeństwo. Prawda jest jednak taka, że nawet dogłębnie przemyślana i ograniczona w swym przeznaczeniu zapadnia, pozostaje zapadnią. Powiedzieć, że jesteśmy rozczarowani planami Apple to mało. W przeszłości firma ta była orędownikiem szyfrowania całościowego (end-to-end), z dokładnie tych samych względów, które kierują EFF i o których pisaliśmy już wielokrotnie. Kompromis Apple w sprawie szyfrowania end-to-end być może zadowoli agencje rządowe w USA i za granicą, ale jest szokującym dla wszystkich tych, którzy polegali na firmie jako liderze w dziedzinie ochrony prywatności i bezpieczeństwa użytkowników.

Apple planuje wprowadzić w każdym swoim urządzeniu dwie niepokojące funkcje. Pierwsza z nich polega na zeskanowaniu wszystkich zdjęć przesyłanych do chmury iCloud Photos, pod kątem tego czy nie pokrywają się one ze zdjęciami znajdującymi się w bazie znanych materiałów związanych z wykorzystywaniem seksualnym dzieci (CSAM), prowadzonej przez Krajowe Centrum Zaginionych i Wykorzystywanych Dzieci (National Center for Missing & Exploited Children - NCMEC). Druga zaś, to funkcja za pomocą, której Apple będzie skanować w poszukiwaniu materiałów o charakterze seksualnym, wszystkie zdjęcia wysyłane lub odbierane przez użytkowników kont komunikatora iMessage należących do osób nieletnich. Funkcja ta będzie aktywowana przez rodziców dziecka i jeśli zdecydują się oni na jej uruchomienie, będą oni powiadamiani o wysłaniu lub odebraniu przez niego zdjęć tego rodzaju.

Jeśli Apple faktycznie wdroży obie wyżej wymienione funkcje "skanowania po stronie klienta", użytkownicy usługi iCloud, dzieci korzystające z komunikatora iMessage oraz wszyscy ci, którzy komunikują się z nieletnimi za pośrednictwem tego programu będą musieli poważnie przemyśleć swoje priorytety w zakresie prywatności i bezpieczeństwa. Być może nawet będą zmuszeni zaprzestać korzystania z tego ostatniego narzędzia, które jeszcze niedawno uchodziło za jedno z bardziej bezpiecznych w swojej kategorii.

Apple otwiera furtkę dla większych nadużyć

Pisaliśmy już o tym wcześniej, ale napiszemy to jeszcze raz: nie da się zbudować systemu skanowania po stronie klienta, który może być używany wyłącznie do wyszukiwania obrazów o charakterze seksualnym wysyłanych lub otrzymywanych przez dzieci. Z tego też względu, nawet jeśli autorom tego pomysłu przyświecały dobre intencje, jego wdrożenie doprowadzi do złamania obietnicy silnego szyfrowania danej użytkownikom komunikatora i otworzy furtkę dla dalszych nadużyć.

To nie jest problem równi pochyłej; mamy tu do czynienia z w pełni sprawny systemem, który pod wpływem zewnętrznej presji, może zostać szybko poszerzony o kolejne funkcje.

Aby poszerzyć wąską zapadnię, którą buduje Apple wystarczy jedynie rozszerzenie parametrów skanowania z użyciem tzw. uczenia maszynowego (machine learning) o dodatkowe rodzaje treści, bądź też uruchomienie mechanizmu skanowania na kontach wszystkich użytkowników, a nie tylko dzieci.

To nie jest problem równi pochyłej; mamy tu do czynienia z w pełni sprawny systemem, który pod wpływem zewnętrznej presji, może zostać szybko poszerzony o kolejne funkcje.

Weźmy za przykład Indie, gdzie niedawno uchwalono przepisy nakładające na platformy komunikacyjne obowiązek identyfikowania źródła wiadomości i wstępnego sprawdzania ich treści. W Etiopii wprowadzono z kolei przepisy wymagające usunięcia treści "dezinformujących" w ciągu 24 godzin, które mogą mieć zastosowanie także do komunikatorów. Wiele innych krajów, często rządzonych przez autorytarne władze, przyjęło podobne regulacje. Zmiany wprowadzone przez Apple umożliwiłyby dokonywanie skanowania, usuwania i raportowania treści przesyłanych w ramach komunikatora wykorzystującego szyfrowanie end-to-end.

Łatwo sobie wyobrazić możliwe nadużycia: rządy, które zdelegalizowały homoseksualizm mogłyby wymagać, aby mechanizm filtrujący został przeszkolony w zakresie ograniczania treści LGBTQ+. Z kolei autorytarny reżim mógłby wymagać, aby klasyfikator był w stanie wykryć popularne rysunki satyryczne wymierzone we władze, bądź ulotki nawołujące do udziału w protestach.

W przeszłości widzieliśmy już tego rodzaju rozwój wypadków. Jedna z technologii pierwotnie stworzonych do skanowania i haszowania obrazów przedstawiających seksualne wykorzystywanie dzieci została później wykorzystana do stworzenia bazy treści "terrorystycznych". Baza ta jest obecnie dostępna dla podmiotów prywatnych, które mogą ją poszerzać i wykorzystywać do uniemożliwiania rozpowszechniania tego rodzaju treści na własnych platformach.

Baza danych zarządzana przez Globalne Forum Internetowe na rzecz Przeciwdziałania Terroryzmowi (GIFCT), jest pozbawiona zewnętrznego nadzoru, pomimo licznych apeli organizacji społecznych. Nie mając możliwości wglądu w tę bazę, nie wiemy czy nadal jest ona wykorzystywana zgodnie ze swoim oryginalnym przeznaczeniem. Pewnym jest jednak, że platformy sieciowe regularnie oznaczają jako potencjalnie terrorystyczne treści krytycznie odnoszące się do przemocy i represji, jak również dzieła sztuki i satyrę.

Skanowanie zdjęć na iCloud Photos: zmniejszenie prywatności

Plan Apple dotyczący skanowania zdjęć przesyłanych do iCloud Photos przypomina w niektórych aspektach pomysł PhotoDNA Microsoftu. Najważniejszą różnicą jest to, że skanowanie Apple'a ma się odbywać bezpośrednio na urządzeniu użytkownika.

W planach Apple baza danych przetworzonych zdjęć CSAM (niemożliwa do poddania zewnętrznemu audytowi) będzie rozpowszechniana wraz z systemem operacyjnym, same zdjęcia zostaną z kolei przetworzone tak, by użytkownik nie mógł się z nimi zapoznać. Porównywanie zdjęć użytkownika ze zdjęciami z bazy będzie zaś dokonywane w taki sposób, by on sam nie był w stanie stwierdzić, czy odkryto między nimi zgodność.

Oznacza to, że gdy funkcje te zostaną wprowadzone, wersja bazy NCMEC CSAM zostanie załadowana na każdy iPhone. Wyniki porównania będą przekazywane do Apple, ale firma będzie w stanie stwierdzić, że ustalono zgodność tylko wtedy, gdy wystarczająca liczba zdjęć zostanie dopasowana zgodnie ze wstępnie ustawionym progiem.

Po wykryciu odpowiedniej liczby zdjęć, zostaną one wysłane do recenzentów Apple, którzy samodzielnie określą, czy zdjęcia są w rzeczywistości częścią bazy danych CSAM. Jeśli zostanie to potwierdzone przez recenzenta, zdjęcia te zostaną wysłane do NCMEC, a konto użytkownika zostanie zablokowane. I znowu, najistotniejszym w całym tym systemie jest to, że niezależnie od zastosowanych w nim mechanizmów ochrony prywatności i bezpieczeństwa, wszystkie zdjęcia przesłane do iCloud będą skanowane.

Powiedzmy to wprost: mechanizm ten nie chroni prywatności użytkowników iCloud Photos, on ją istotnie zmniejsza.

Apple posiada obecnie możliwość przeglądania zdjęć przechowywanych w chmurze iCloud Photos, nie skanuje ich jednak. Organizacje rzecznicze zwróciły się do firmy o wyeliminowanie tej możliwości. Apple zdecydowało się jednak na odmienny krok i przyznało sobie większy dostęp do informacji na temat treści użytkowników ich usług.

Uczenie maszynowe i powiadomienia rodzicielskie w iMessage: odejście od mocnego szyfrowania

Druga główna nowa funkcja Apple to dwa rodzaje powiadomień opartych na skanowaniu zdjęć wysyłanych lub otrzymywanych za pośrednictwem komunikatora iMessage. Aby wdrożyć te powiadomienia, Apple uruchomi na każdym urządzeniu klasyfikator uczenia maszynowego, zaprojektowany do wykrywania "obrazów o charakterze seksualnym." Według Apple, funkcje te będą ograniczone (na starcie) do użytkowników mieszkających w USA w wieku poniżej 18 lat, którzy korzystają z usługi Konto Rodzinne.

Na gruncie tego rozwiązania, gdy ktoś korzystający z konta posiadanego przez dziecko poniżej 13 roku życia będzie chciał wysłać obraz, który klasyfikator uczenia maszynowego na urządzeniu uzna za obraz o charakterze seksualnym, użytkownikowi wyświetli się powiadomienie, że jego rodzice zostaną poinformowani o treści przesyłanej wiadomości. Jeśli dziecko w wieku poniżej 13 roku życia mimo to zdecyduje się wysłać tę treść, będzie musiało zaakceptować fakt, że jego rodzic zostanie o niej powiadomiony, a sam obraz zostanie nieodwołalnie zapisany w sekcji kontroli rodzicielskiej na telefonie rodzica, aby ten mógł go później obejrzeć. W przypadku użytkowników w wieku od 13 do 17 lat, pojawią się podobne powiadomienia ostrzegawcze, jednak bez powiadamiania rodzica.

Podobnie, jeśli osoba w wieku poniżej 13 roku życia otrzyma obraz, który w aplikacji iMessage zostanie uznany za obraz "o charakterze seksualnym", zanim będzie mogła ona zobaczyć zdjęcie, pojawi się powiadomienie, że jej rodzic zostanie poinformowany o otrzymaniu przez nią obrazu o charakterze seksualnym. I znów, jeśli użytkownik w wieku poniżej 13 roku życia zaakceptuje zdjęcie, rodzic zostanie o tym powiadomiony, a zdjęcie zostanie zapisane na jego telefonie. Użytkownicy w wieku od 13 do 17 lat również otrzymają powiadomienie ostrzegawcze, ale bez powiadamiania rodzica.

Oznacza to, że jeśli, przykładowo, osoba niepełnoletnia korzystająca z iPhone'a bez włączonej funkcji skanowania wyśle zdjęcie do innej osoby niepełnoletniej, która ma ją włączoną, wysyłający nie otrzyma informacji o tym, że iMessage uznał, że zdjęcie ma "charakter seksualny", a także nie otrzyma informacji o tym, że rodzic odbiorcy zostanie powiadomiony. Rodzice odbiorcy wiadomości zostaną więc poinformowani o jej treści bez zgody nadawcy. Ponadto po wysłaniu lub otrzymaniu "zdjęcia o wyraźnie seksualnym charakterze" nie będzie można go już usunąć z urządzenia użytkownika poniżej 13 roku życia. Wysyłając lub odbierając tego rodzaju treści, osoba poniżej 13 roku życia ma możliwość ich odrzucenia bez powiadamiania rodzica.

Wysyłając lub odbierając tego rodzaju treści, osoba poniżej 13 roku życia ma możliwość ich odrzucenia bez powiadamiania rodzica.

Podkreślenia wymaga również to, że dla ustalenia, czy dany obraz ma charakter seksualny Apple zdecydowało się skorzystać z technologii uczenia maszynowego, która znana jest z tego, że bardzo trudno poddaje się audytowi.

Wyniki licznych analiz przeprowadzonych w ostatnich latach dowodzą jednak, że technologie uczenia maszynowego, używane bez nadzoru człowieka, mają tendencję do błędnego klasyfikowania treści, w tym także tych "o charakterze seksualnym". Kiedy platforma blogowa Tumblr wprowadziła filtr dla treści seksualnych w 2018 roku, głośno było o oflagowaniu przez nią jako pornograficzne wielu rodzaju innych obrazów, w tym zdjęć szczeniaków szpiców miniaturowych oraz fotografie osób całkowicie ubranych. Podobne próby kontrolowania nagości na Facebooku doprowadziły z kolei do usunięcia z platformy zdjęć znanych rzeźb, takich jak słynna Mała Syrenka z Kopenhagi. W przeszłości filtry te wielokrotnie przyczyniły się do ograniczania swobody ekspresji i istnieje wiele powodów by sądzić, że w przypadku Apple będzie tak samo.

Ponieważ wykrywanie "obrazów o wyraźnie seksualnym charakterze" będzie polegało na wykorzystaniu uczenia maszynowego do skanowania treści wiadomości bezpośrednio na urządzeniu, Apple nie będzie już mogło uczciwie nazywać iMessage, “komunikatorem wykorzystującym szyfrowanie end-to-end". Apple i jego obrońcy mogą utrzymywać, że skanowanie przed lub po zaszyfrowaniu lub odszyfrowaniu wiadomości nie narusza obietnicy "szyfrowania end-to-end", ale byłoby to czysto retoryczny zabieg mający na celu ukrycie radykalnej zmiany stanowiska firmy wobec mocnego szyfrowania. Jakkolwiek tego nie nazwie Apple, nie będzie to już bezpieczne przesyłanie wiadomości.

Dla przypomnienia, bezpieczny system przesyłania wiadomości to taki, w którym nikt poza użytkownikiem i zamierzonymi odbiorcami nie może przeczytać wiadomości lub w inny sposób przeanalizować ich treści, aby wywnioskować, o czym owi użytkownicy rozmawiają. Przy szyfrowaniu end-to-end nawet serwer, przez który przechodzi wiadomość nie dysponuje możliwością odczytania jej treści.

Jeśli jednak ten sam serwer ma kanał umożliwiający mu ujawnienie znacznej części treści wiadomości, to nie jest to szyfrowanie typu end-to-end. W omawianym przez nas przypadku, choć Apple nigdy nie zobaczy obrazów wysyłanych lub odbieranych przez użytkownika, to jednak dysponuje klasyfikatorem, który skanuje obrazy i dostarcza powiadomienia do rodziców. Oznacza to, że Apple będzie również w stanie poszerzać klasyfikator o inne rodzaje danych, bądź też wysyłać powiadomienia do szerszego grona odbiorców, tym samym cenzurując wypowiedzi i generując efekt mrożący.

Ale nawet bez takich rozszerzeń, system ten da tym rodzicom, którzy wcale nie mają na uwadze dobra swoich dzieci, kolejny sposób na monitorowanie i kontrolowanie tych ostatnich, ograniczając tym samym potencjał Internetu do poszerzania horyzontów tych osób, których życie w przeciwnym razie byłoby dużo uboższe. A ponieważ plany rodzinnego współdzielenia mogą być również wykorzystywane przez toksycznych partnerów, możemy sobie też wyobrazić, sytuację, w której funkcji ta posłuży jako rodzaj oprogramowania szpiegującego (stalkerware).

Ludzie mają prawo do komunikowania się z poszanowaniem ich prywatności i bez cenzury, także wtedy gdy są nieletni. Apple powinno podjąć właściwą decyzję i porzucić plan wbudowania zapadni w urządzenia swych użytkowników.

POWIEDZ APPLE, BY NIE SKANOWAŁO NASZYCH TELEFONÓW.

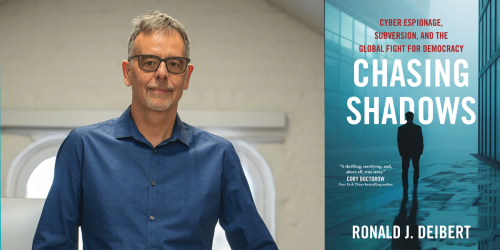

Read further on this topic:

- If You Build It, They Will Come: Apple Has Opened the Backdoor to Increased Surveillance and Censorship Around the World

- How LGBTQ Content is Censored Under the Guise of "Sexually Explicit"

- EFF Joins Global Coalition Asking Apple CEO Tim Cook to Stop Phone-Scanning

- Apple’s Plan to Scan Photos in Messages Turns Young People Into Privacy Pawns

- 25,000 EFF Supporters Have Told Apple Not To Scan Their Phones

- Delays Aren't Good Enough—Apple Must Abandon Its Surveillance Plans